本篇文章3168字,读完约8分钟

雷锋。这篇文章来自于辛勤工作的开放班|阿尔法戈特别会议的分享。分享嘉宾,移动电话网络工程师,李莉。

首先,什么是深度学习?

与传统的机器学习相比,我认为深度学习的最大特点是不需要(太多)特征工程。

在机器学习流行之前,它是一个基于规则的系统。因此,要做发音,你需要知道语音学,要做自然语言处理,你需要很多语言学知识,要做深蓝,你需要很多象棋大师。统计方法成为主流后,领域知识不再那么重要,但我们仍然需要一些领域知识或经验来提取合适的特征,这往往决定了机器学习算法的成败。

对于自然语言处理,特征相对容易提取,因为语言本身是高度抽象的;对于语音或图像,我们人类很难描述如何提取特征。例如,当我们辨认一只猫时,我们模糊地认为猫有两只眼睛,一个鼻子和一条长尾巴,它们之间有一定的制约关系。例如,从两只眼睛到鼻子的距离可能相似。但是如何用像素来定义“眼睛”?如果你仔细想想,你会发现它很难。当然,我们有很多特征提取的方法,比如边缘轮廓提取等等。

但是人类的学习似乎不需要这么复杂。我们只需要给人们看一些猫的照片,他们就能知道猫是什么。人们似乎能够自动“学习”特征。你给他看一些猫的照片,然后问他猫有什么特征。他可能会预约告诉你猫有什么特征,甚至猫的独特特征,而豹子或老虎没有。

深度学习最近如此流行的一个重要原因是不需要提取特征。

就机器学习用户而言,我们过去做的大部分是特征工程,然后调整一些参数,通常是为了防止过度拟合。随着深入学习,我们似乎无事可做!用足够的训练数据来标记它。

语音识别、图像识别和自然语言处理等特定应用是相对成熟的领域。在其他一些领域,如防病毒和天气预报。只要需要机器建模,特征就很难描述,可以在有足够标记数据的地方尝试深度学习。

第二,人类也是如此,阿尔法狼和深蓝的区别

深蓝有两项主要技术:阿尔法-贝塔搜索和估值模型。搜索,我们都应该知道,机器学习更多的是领域专家(象棋大师)来提取特征(如棋子的价值、位置的作用、棋子的保护和威胁关系等)。),然后建立一个复杂的模型来判断情况(不清楚是否使用了机器学习)。

alphago的核心技术是mcts搜索和cnn神经网络。美国有线电视新闻网使机器学习人类的“棋感”,这样就不会在开始和中间的游戏中落后,然后在最后的游戏中用强大的计算能力打败人类。

因为深层神经网络非常流行,人们可能认为它是赢得阿尔法战士的关键,但我不这么认为。

根据田元东和阿尔法戈的论文,如果你不做任何搜索,只是根据“棋感”(实际上,这是估值功能),cnn最好达到kgs 3d的水平,我估计这只是业余水平。Mcts算法可以在没有价值网络的9 x 9棋盘上击败人类高手,间接证明了alphago在搜索(计算)中的重要作用。最初基于搜索的软件在游戏的开始和中间崩溃或丢失太多,所以它不能反映搜索的优势。此外,alphago使用价值网络,这确保了即使在搜索中有一些小问题,人类学的棋感也不会偏离太多。

Alphago的特点是:在游戏开始和中间,通过人类的棋盘来学习棋感(可以理解为记忆棋盘,但比死记硬背要好,具有一定的泛化能力),然后游戏结束时,人类的计算能力就会崩溃,就像李昌镐以前一样,面前什么也看不到,但你不能打败他,你也无能为力。

3.在比赛之前,许多人认为阿尔法戈会输。这个判断的偏差是什么?

以前,我们太关注阿尔法戈的神经网络部分。事实上,赢得国际象棋的关键可能在于最终结果的计算。我们没想到。

4.对于人工智能研究来说,赢得或输掉整个比赛意味着什么?作为一个对人工智能感兴趣的工程师,我既高兴又难过。

快乐是因为我们可以“创造”比自己“更聪明”的机器。悲伤就像教拳击的师傅看到自己徒弟的水平已经超越自己,不禁感叹自己“老而无用”。但这是大势所趋。人工智能将不可避免地在许多领域超越人类。

5.为什么阿尔法戈在第一场比赛的下半场走得越来越慢?

这是一个计算机时间策略的问题,因为根据前面的分析,后局是阿尔法围棋赢棋的关键,所以在后局投入更多的时间是一个合理的策略。

6.如果计算能力很强,阿尔法戈能直接得到最优解吗?

从数学上讲,围棋有一个最优的走法,即在游戏结束时用mini-max搜索最优路径(可能有多条路径,但至少有一条路径),然后你就可以知道在最优情况下黑棋赢白棋的网格数。

我认为阿尔法戈远远不是最佳解决方案,尤其是在游戏的开始和中间阶段。事实上,这间接地表明,人类在开始时远非最佳解决方案。几千年来,人类不能下太多的国际象棋(而水平较低的人下的国际象棋对整个人类没有太大帮助)。我们认为一个开局是好是坏,我们只能根据这个布局在水平相近的高手下的胜率来猜测它是好是坏。然而,如果我们在过去的50个步骤中有很大的错误,当我们向前扩展时,累积的错误会更大。我们可能经常忽略一次难看的散步,这可能是“支持”开始的关键。

当然,阿尔法戈的结局比其他人更糟糕,所以你可以通过玩你自己的游戏来学习,并将错误向前传播。但是因为这个问题本质上是np问题,即使它使用mcts方法来避免“明显不好的”行走。然而,由于围棋的复杂性,某种“难看”的走法可能只是一个关键的赢家或输家?此外,根据前面的分析,即使每一步都能达到99%的精确度,向前推进100步的可能性基本为零。

因此,如果人类不能解决np问题,不能提出一个计算能力超过图灵机的计算模型,那么人类制造的机器就不可能解决这个问题(当然,这只是我的直觉,我不知道它是否能被数学证明)。

然而,即使如此,能够制造出和人类一样的机器也是有意义的,尽管它们在质量上不能超过人类,但在数量上可以超过人类。

7.什么是阿尔法围棋学习,它是如何学习的?

阿尔法戈由人类大师赛作为训练数据进行训练,也就是说,在给定的情况下,用人类大师的下一步动作来结束这种情况的最佳方式。通过大量这样的数据,美国有线电视新闻网可以自动学习类似人类的“棋感”。当然,虽然cnn不需要太多的功能,但是alphago实际上使用了一些关于围棋的知识,比如《荀子》。虽然我是个业余爱好者,但我也知道招聘的成功取决于六条线上是否有对手。此外,象棋的水平也是相关的。即使有回应,如果棋局太低,也有可能成功。这就要计算了。

此外,阿尔法戈还通过深入研究与自己对弈提高了自己的“棋感”。就我个人而言,我认为我们应该加强学习的原因可能是很多人的“棋感”是从以前的棋谱中学来的,阿尔法戈可以通过深入学习选择更合适的“棋感”。

这种“棋感”能更好地适应其后来的计算能力。就好像如果我不擅长下棋,我会有一个稳定的开始。我的计算能力超强,所以我会和你一起战斗,做出复杂的改变。

阿尔法去学习一夜能达到什么样的效果?

很难说。就我个人而言,我认为他们不应该训练新的模型,因为即使在深度神经网络中,参数调整也很棘手。他们现在处于领先地位,所以他们不应该冒险更新模型。

8.除了围棋,阿尔法围棋还可以用在哪些领域?

alphago本身的技术是mcts和cnn,而mcts实际上属于强化学习领域。

深度学习可以用在很多领域,如前所述,只要这个领域需要建立一个模型来预测,并且有很多标记的训练数据。

强化学习是关键。我认为强化学习是人类社会的学习过程,它通过行为改变世界,然后从反馈中学习。虽然人类也有一些监督学习,如学校教育,他们把以前的结论作为培训数据。但是大多数创新(获取新知识或修正旧知识)依赖于强化学习。我们以前在学校学到的可以被视为先验知识,但我们仍然需要自己的行动和尝试。纸上总会觉得肤浅,从来不知道要实践这件事。

例如,如果我们想让机器人在火星上生存,我们不知道火星的环境,所以我们只能根据地球的数据训练一个基本的先验模型。火星之后,机器人必须能够通过强化学习来学习新知识,以适应新环境。

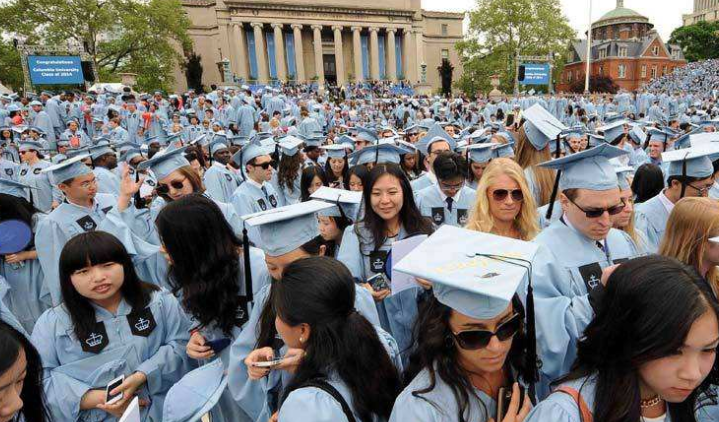

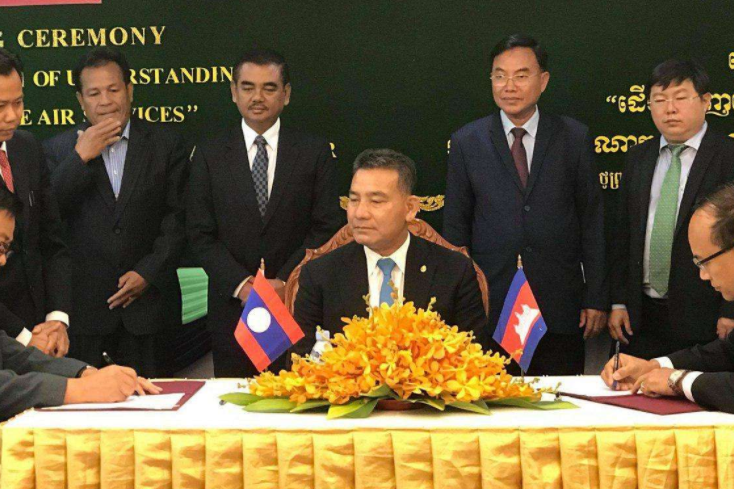

图片来自:对话